Home > Le rôle crucial d’Apache Kafka et Hadoop en Data Engineering

Résumé Audio :

Vous vous sentez submergé par un flux incessant de données sans parvenir à leur donner du sens ? Cet article vous explique comment Apache Kafka et Hadoop, deux géants du big data, s’allient pour rationaliser votre gestion des données et booster leur traitement. Découvrez plutôt comment ces outils redéfinissent les règles de l’infrastructure de données tout en dopant vos applications à grande échelle !

Dans l’univers des systèmes distribués, Apache Kafka et Hadoop forment un duo puissant pour les entreprises. La plateforme Kafka brille dans la diffusion de flux en continu, tandis que Hadoop excelle dans le traitement par batch. Mais comment fonctionnent-ils ensemble au quotidien ?

Voici leurs principales complémentarités techniques :

Cette symbiose technique répond aux défis des entreprises modernes qui gèrent à la fois des flux continus et des historiques volumineux.

Leur fonctionnement distribué repose sur des clusters élastiques. Mais concrètement, comment ça marche ? Prenons l’exemple d’un réseau social : Kafka ingère chaque interaction utilisateur, tandis qu’Hadoop stocke l’historique complet pour l’analyse hebdomadaire.

Un cas typique ? La supervision d’applications. Les logs remontent via Kafka en direct, permettant de détecter les incidents instantanément. Parallèlement, Hadoop accumule ces sources d’information pour des rapports mensuels. Pour maîtriser ces technologies, explorez nos formations sur les fondamentaux d’Apache Kafka et l’initiation à Hadoop.

Notifions que les entreprises qui utilisent Kafka l’associent à un système de stockage massif type Hadoop.

*Source : Étude Data Platforms 2023

Vous vous demandez quelle technologie big data choisir pour vos projets data ? Analysons ensemble Kafka, Hadoop avec un regard concret sur leurs applications réelles.

| Caractéristique | Kafka | Hadoop |

|---|---|---|

| Traitement | Temps Réel (Streaming) | Batch (Lots) |

| Latence | Faible | Élevée (tolère latence E/S) |

| Tolérance aux pannes | Élevée (réplication des partitions) | Élevée (HDFS réplique les blocs) |

| Cas d’usage principal | Ingestion et traitement de flux de données en temps réel | Stockage et traitement de grands ensembles de données |

| Architecture | Plateforme de streaming distribuée | Framework de stockage et de traitement distribué |

| Légende: Ce tableau compare Kafka et Hadoop sur des aspects clés tels que le traitement, la latence, la tolérance aux pannes et les cas d’usage. | ||

Pour y voir plus clair, décortiquons les spécificités de chaque solution :

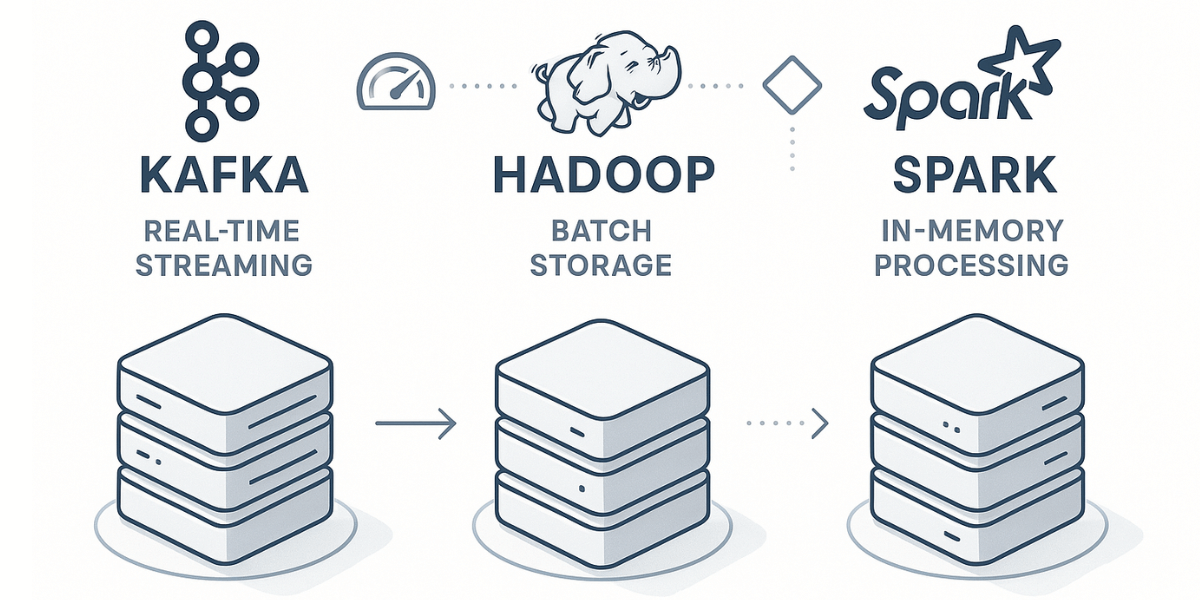

En pratique, les pipelines ETL modernes mixent souvent ces outils. Kafka fait office de tampon réactif pour les streams, Spark accélère les transformations, tandis que les clusters Hadoop persistent certaines données. Mais comment orchestrer cette mécanique complexe ?

Avec l’essor du cloud, des services comme Azure HDInsight simplifient le déploiement de ces plateformes. Le serverless permet notamment de dimensionner automatiquement les clusters Kafka selon la charge – idéal pour les entreprises avec des besoins variables.

Côté sécurité, les bonnes pratiques évoluent. Le chiffrement des flux Kafka (via TLS) et la gestion fine des accès dans Hadoop restent primordiaux. Les entreprises régulées ajoutent souvent une couche de journalisation centralisée pour auditer les sources de données.

Signalons que l’intégration avec d’autres composants (comme les bases NoSQL ou les outils BI) influence aussi le choix technologique. Une plateforme bien conçue doit permettre des échanges fluides entre tous ces éléments, sans créer de goulots d’étranglement.

L’association de Kafka et de clusters Apache révolutionne plusieurs industries. Examinons comment ces technologies s’appliquent sur le terrain, avec des exemples parlants.

Dans la finance, les entreprises combinent Kafka à des plateformes cloud pour détecter les fraudes. Le système capte des streams de transactions en direct, tandis que les clusters Apache croisent ces données avec des sources historiques.

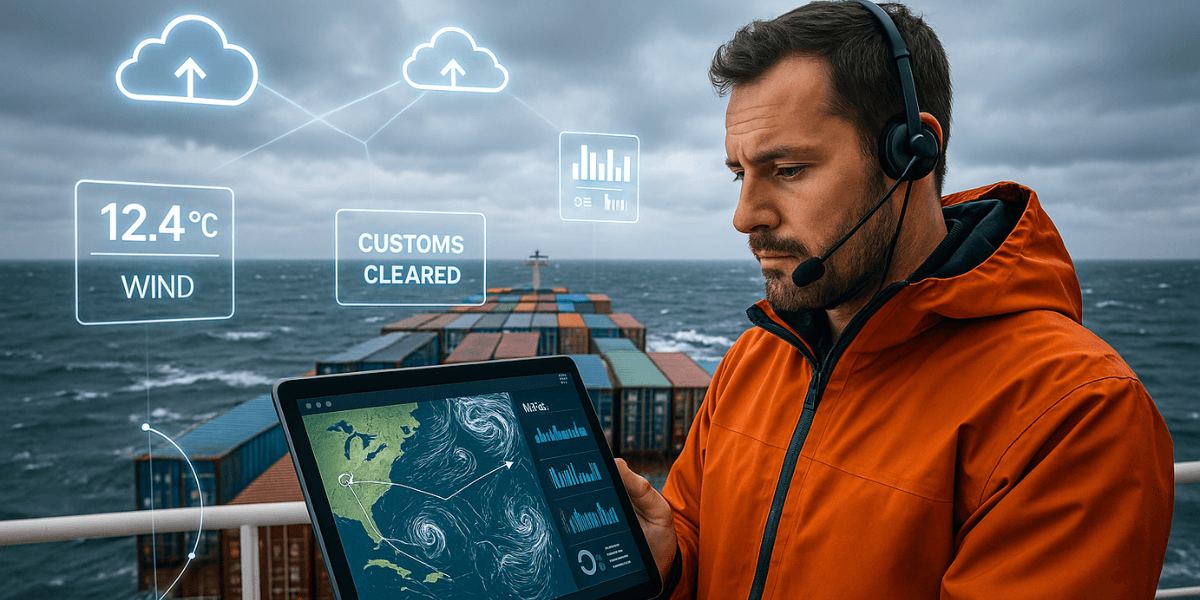

Le transport maritime montre aussi des usages marquants. Grâce aux flux IoT traités par Kafka, les logisticiens optimisent leurs routes en temps réel. Les architectures scalables permettent ici de fusionner données météo, positions GPS et contraintes douanières.

Signalons enfin le retail, où les entreprises exploitent ces outils pour personnaliser leurs promotions. Les streams de comportements clients transitant par Kafka, tandis que les clusters analysent les tendances sur des pétaoctets de données. Résultat : des campagnes marketing qui touchent juste, sans compromettre la vie privée.

Pour progresser en data engineering avec Kafka et Hadoop, une formation solide s’impose. Les certifications Apache et celles des fournisseurs cloud (AWS, GCP, Azure) constituent un vrai atout pour les professionnels. Voyons comment structurer votre parcours. Par où commencer ?

L’idéal ? Alterner entre travaux pratiques sur labos et cours en ligne. Maîtrisez d’abord les bases avant de vous attaquer aux architectures complexes. Les entreprises apprécient particulièrement cette double approche théorique et pratique. Un conseil : documentez systématiquement vos expérimentations !

Voici une méthode éprouvée pour maîtriser Kafka et les plateformes de big data :

Cette approche progressive vous permettra de développer des compétences recherchées sur le marché.

Pour vos tests, privilégiez les sandboxes (Cloudera, Hortonworks) et les simulateurs locaux. Ces environnements isolés sont parfaits pour explorer les architectures sans risque. Une astuce : commencez toujours avec un cluster minimaliste avant de scaler.

La clé ? Une configuration rigoureuse de vos POC. Documentez chaque paramètre et testez vos applications sous différentes charges.

Découvrez les outils indispensables pour expérimenter :

Ces bonnes pratiques vous aideront à maîtriser les plateformes de traitement distribué.

Les plateformes Apache Kafka évoluent rapidement dans les architectures cloud. Voyons ce qui se profile à l’horizon pour ces clusters de données.

L’intégration avec le Machine Learning en production gagne du terrain. Apache Kafka sert notamment à alimenter les modèles ML au sein des clusters, aussi bien en streaming qu’en traitement par lots. Une avancée qui simplifie la diffusion des prédictions en temps réel. Mais attention : quid des besoins spécifiques aux applications de batch ?

Du côté infrastructure, les conteneurs redéfinissent les déploiements. Kubernetes facilite la gestion élastique des clusters, surtout pour les streams haute fréquence. Comment adapter ces solutions aux architectures cloud hybrides ?

La traçabilité des sources devient critique dans les entreprises. Les métadonnées structurées permettent désormais de retracer l’origine des flux, tout en garantissant leur qualité. Un point clé pour les clusters distribués !

Reste le défi RGPD dans les architectures décentralisées. Les entreprises doivent sécuriser les flux sensibles tout en assurant leur diffusion transverse. Bonne nouvelle : certaines plateformes comme Apache Kafka proposent maintenant des fonctionnalités natives de chiffrement.

Avec l’explosion des volumes, les entreprises doivent jongler entre performance et budget. Les modèles TCO intègrent désormais le coût caché des clusters surdimensionnés. Une équation complexe, surtout pour le streaming temps réel.

La compression intelligente et l’archivage stratifié émergent comme solutions. En parallèle, l’optimisation des requêtes sur les sources batch permet de réduire l’empreinte matérielle. Résultat ?

Vous le savez peut-être : maîtriser Kafka et Hadoop reste indispensable pour briller en data engineering. Ces technologies, lorsqu’elles sont combinées à Spark, décuplent vos capacités de traitement des données massives. Un trio gagnant pour gérer des flux à grande échelle ! Alors, prêt à booster vos compétences Big Data et à imaginer les architectures de demain ?

Comment optimiser Kafka et Hadoop pour des données IoT à débit variable ?

Ajustez Kafka (partitions, compression, batchs) selon le débit. Kafka Connect facilite l’intégration avec les capteurs. Utilisez un monitoring temps réel (Prometheus, Grafana) pour ajuster dynamiquement les ressources. Côté Hadoop, YARN permet de gérer la montée en charge lors des pics d’ingestion.

Comment intégrer Kafka et Hadoop avec une solution DLP ?

Implémentez des règles DLP dans les Consumers Kafka ou utilisez un outil DLP externe. Côté Hadoop, chiffrez les données, appliquez un contrôle d’accès (RBAC) et anonymisez les champs sensibles. Exploitez les API DLP pour centraliser la gestion des règles et des alertes.

Quelles sont les alternatives open source à Spark dans un écosystème Kafka/Hadoop ?

Apache Flink est adapté au traitement de flux temps réel. Storm est léger pour les événements simples. Apache Beam permet des pipelines multi-moteurs (Spark, Flink). Pour le batch, MapReduce reste utilisable. Dask est une alternative Python pour le calcul distribué.

Comment assurer la reprise après sinistre pour Kafka et Hadoop en cloud hybride ?

Utilisez MirrorMaker 2 pour répliquer Kafka, et la réplication HDFS pour Hadoop. Automatisez le basculement, la redirection du trafic et la restauration des services. Des solutions comme BDR ou les snapshots cloud renforcent la résilience.

Quels patterns d’architecture utiliser avec Kafka et Hadoop en microservices ?

Plusieurs patterns sont adaptés :

Nos dernières publications

S’abonner à la Newsletter

Consultez nos formations et sessions confirmées

Nous utilisons des cookies afin de vous garantir une expérience de navigation fluide, agréable et entièrement sécurisée sur notre site. Ces cookies nous permettent d’analyser et d’améliorer nos services en continu, afin de mieux répondre à vos attentes.

ITTA

Route des jeunes 35

1227 Carouge, Suisse

Monday to Friday

8:30 AM to 6:00 PM

Tel. 058 307 73 00

ITTA

Route des jeunes 35

1227 Carouge, Suisse